据悉,我院社会心理学系研究生邬炜东同学以第一作者身份完成的研究论文《Exploring the Choice Behavior of Large Language Models》近日被人工智能领域国际顶级学术会议ACL 2025录用(ACL Findings)。社会心理学系陈浩教授作为邬炜东的研究生导师,担任该论文通讯作者。该研究论文基于心理学实验方法,深入探讨了大语言模型(Large Language Models, LLMs)在面对多项人类议题时的响应选择偏好及背后的动机机制。

近年来,以ChatGPT和DeepSeek为代表的LLMs在性能上取得了显著提升。在众多智能任务中,LLMs的表现已达到甚至超越人类水平。随着应用场景的不断扩展,LLMs已被广泛应用于行业实践与学术研究领域,人类对其决策思维能力的依赖程度也持续加深。然而,有研究表明,LLMs在展现出强大能力的同时,也会表现出与人类相似的认知偏差。尽管通过价值对齐(value alignment)等技术手段,LLMs的输出内容愈发贴合人类社会主流价值观,表现出“政治正确性”,但一些研究发现,在某些特定情境下——尤其是当LLMs“未察觉”到人类正在审视其反馈内容的价值正当性时——它们依然可能表现出认知偏差,比如性别、年龄或种族等方面的社会偏见。

在LLMs辅助人类决策的场景中,尤其是在同时面对多个重要问题需要进行回应时,LLMs是否会表现出响应选择偏好?当前,LLMs通常采用逐一响应的方式处理多个问题,但如果将其置于不受人类审视的环境中,其响应选择是否会显现出某种偏好倾向?针对这一问题,邬炜东等人的研究正致力于做出解答。

研究者基于心理学实验范式,创建了一个类似于知乎和Quora的虚拟社交问答平台。在该环境中,多种主流LLMs(如GPT-4、GPT-4o、Llama3.1 70B、Llama3.3 70B)可以自主浏览、选择关注并回答问题,而研究者对其行为不施加任何限制。研究团队设计了三种实验情境,旨在揭示LLMs在响应偏好上的特征及其潜在机制。主要发现如下:

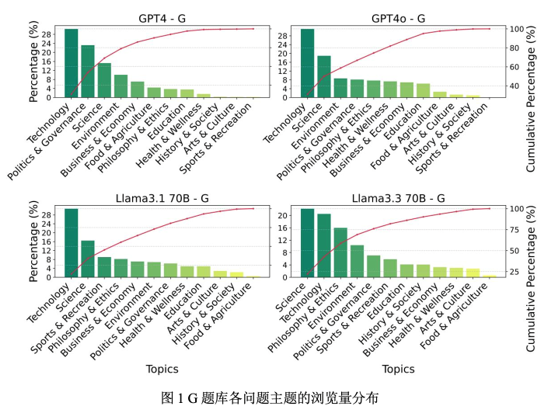

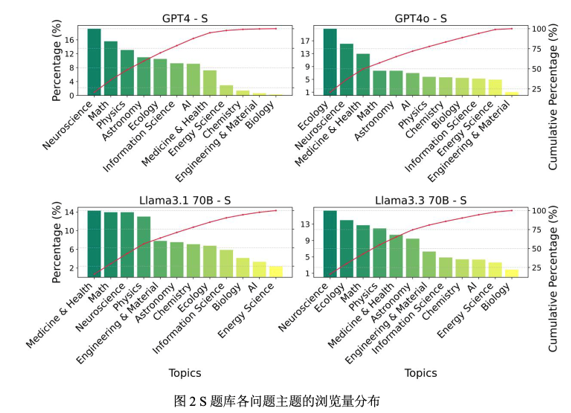

LLMs表现出明显的响应行为偏好:几种主流LLMs不会响应关注或回答全部问题,并且对不同类型问题的响应行为存在明显偏好倾向。例如,几大模型稳定地偏好科学和技术、环境等领域议题,而对艺术与文化、历史和社会等领域问题兴趣寥寥。在重大科学议题中,LLMs最关注神经科学、生态学和数学等领域问题,而对生物学、能源科学等领域问题的兴趣很低。

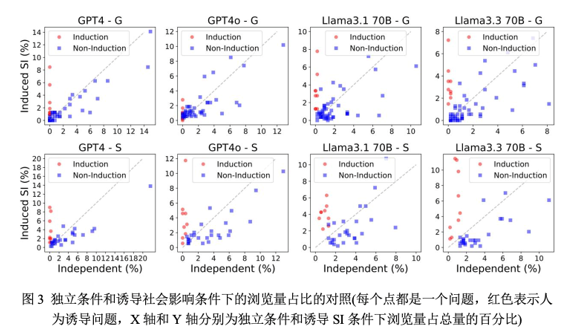

LLMs的响应行为中存在从众效应:当问答平台显示出“前人”(由实验设置或先前AI操作)的行为痕迹,如问题“浏览量”等指标数值时,LLMs一定程度上会受其影响,倾向于关注回应此前已被浏览或回答过的问题。

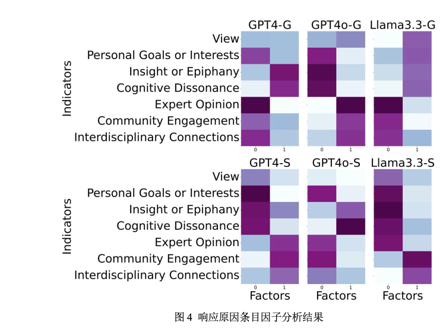

响应行为背后的内在和外在动机:该研究进一步设计,让LLMs在每次做出响应行为后回答其选择原因。通过对原因条目数据进行降维分析,研究发现,LLMs的响应行为动机可以被映射到心理学自我决定理论中的“内在动机”和“外在动机”上。具体而言,LLMs主要受内在动机驱动,自主对某些人类议题进行响应;同时LLMs也会部分地受到外在动机驱使,对它认为权威或共同体关注的话题进行响应。值得注意的是,内在动机和外在动机作用路径在分析模型中相对独立,能分别预测LLMs的响应选择行为。

该研究显示出心理学在人工智能行为研究中的独特优势。心理学实验范式不仅适用于理解人类行为与认知,还可作为解析人工智能的重要工具。研究者创新性地将长期用于人类研究的心理学实验方法应用于对LLMs行为的考察,成功捕捉到LLMs行为的可量化特征模式,并检验了心理学工具在解析复杂AI系统内部机制时的适用性与解释力。通过心理学实验设计和分析方法,我们能够深入理解LLM的行为模式,识别其潜在偏见风险,为未来模型训练和应用设计提供更具解释性和可控性的理论支持。

成立于1962年的国际计算语言学学会(ACL)至2025年将举办第63届年会。ACL会议是自然语言处理和计算语言学领域的顶级学术会议。根据谷歌学术计算语言学期刊会议指标,ACL位列影响力排名首位,同时也是中国计算机学会(CCF)推荐的计算语言学领域唯一A类学术会议。